Contents

✅ 結論:一律禁止も、無制限利用も“リスク”

ChatGPTやCopilotなどの生成AIが普及し、

企業では「AIをどう扱うべきか?」が本格的な課題になっています。

❌ 全面禁止 → 非効率&人材流出のリスク

✅ 活用推奨 → 情報漏洩・誤情報・業務依存リスクも

そのため、**「ルールを整えた上で積極的に活用する」**のが、最も現実的な選択肢です。

🔍 実際に分かれる企業のAI対応方針(2025年版)

| 方針 | 例 | 背景理由 |

|---|---|---|

| ❌ 全面禁止 | 銀行・公的機関・インフラ企業など | セキュリティ・機密保持を最優先 |

| ⚠ 部分制限 | 大手IT・製造業・自治体など | 条件付き許可(例:業務での使用は承認制) |

| ✅ 活用推奨 | コンサル・広告・ベンチャー・教育機関 | 生産性向上と競争力を優先し、利用を制度化 |

🧠 ChatGPT・Copilot等の企業活用で得られる効果

✅ 生産性の向上

- メール文・提案書・議事録などの作成が半自動化

- 会議内容のリアルタイム要約や翻訳

✅ アイデア出し・ブレスト支援

- 商品企画・キャンペーン案・名称候補などをAIと対話で生成

✅ 業務の標準化・属人化防止

- 社員が使うプロンプトやテンプレを共有化できる

🔐 懸念されるリスクとその対策

| リスク | 想定される問題例 | 対策 |

|---|---|---|

| 情報漏洩(社外サーバー利用) | 顧客情報や開発中データの無断入力 | プロンプト管理・ログ取得・社内AIの導入 |

| 不正確な情報 | ChatGPTが事実でない内容を自信満々に返す | 出典確認/AIを「案」として活用 |

| 社員の過信・依存 | 判断力や情報収集力が低下 | 教育とガイドラインの整備 |

| 著作権・倫理 | 無断生成による商用利用や差別表現の懸念 | 利用範囲の制限と定期的な研修 |

🏢 社内導入時にやるべき5ステップ

- 目的を明確にする(業務効率化/アイデア補助/問合せ対応など)

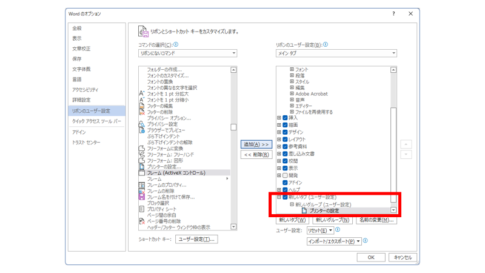

- ポリシーを策定する(NG用途・入力禁止情報・保存ルールなど)

- 利用ツールを統一する(ChatGPT/Copilot/社内独自AIなど)

- ログ管理・社内利用プロンプトの整備

- 教育と定期レビューを行う

📋 社内利用ガイドラインの雛形(抜粋)

- ✅ 利用目的:業務支援・文書作成・調査の補助

- ✅ 禁止事項:個人情報・顧客情報・未公開資料の入力

- ✅ ツール範囲:ChatGPT(Plus)、Microsoft Copilot など

- ✅ 社内共有:有用なプロンプトはナレッジとして残す

- ✅ 責任所在:AIの出力内容の確認責任は利用者にある

🧩 導入モデルケース(部署別)

| 部署 | 活用事例 |

|---|---|

| 営業 | メールの下書き、商談メモの要約、顧客調査のサポート |

| 管理部門 | 社内規定の言い換え、報告書作成補助 |

| 開発・IT | コード補完、エラー修正案の提案、技術文書の翻訳 |

| マーケ | 広告文案の案出し、SNS投稿の自動生成 |

🚫 禁止しても意味がない?「シャドーAI利用」の現実

たとえ社内でAI利用を禁止しても…

📱「スマホでChatGPTに聞いた」

🏠「家で作ったAI資料を翌日提出」

💬「SNSで得たプロンプトを勝手に使っている」

こうした“見えない非公式利用(=シャドーAI)”は、実際には水面下で多発しています。

🔍 なぜ起きる?

- AIを使うと圧倒的に効率が良いと知っている

- 「禁止されてるけど便利だから使いたい」という心理

- 明確な指針や代替ツールが社内に存在しない

🧯 対策:禁止よりも「ルールを設けた利用推奨」が現実的

| 対応方針 | 結果 |

|---|---|

| ❌ 無言の禁止 | 社員がスマホや自宅で勝手に使い、情報漏洩リスクが増加 |

| ✅ ポリシー付き活用 | 利用可能なツールと用途を明確化 → 安全に業務効率を高められる |

✅ 企業が取り組むべきこと

- 📋 「社外でのAI利用」も対象とした利用ガイドラインを整備

- 📲 業務利用できる公式ツール(例:ChatGPT Enterprise/Copilot)を用意

- 📚 社員教育で“安全な使い方”を伝える

- 🧠 「ダメだから使わない」ではなく、「どう使えば安全か」を教える

🔚 まとめ|AIは“禁止”より“使いこなす”ことが生き残り戦略

- 🛑 禁止一辺倒では、若手人材や競合に差をつけられるリスク

- ✅ 教育・ポリシー・制限を設けたうえでの“活用推奨”がベスト

- 🤖 AIと共に仕事を再設計する視点が、組織の成長に直結

コメントを残す